Как запустить DeepSeek на своем сервере или VPS

DeepSeek AI представляет собой производительную открытую ИИ-модель, способную функционировать без GPU в зависимости от выбранной модели. Для локального запуска ИИ-моделей используют различные инструменты.

Инструменты для LLM

-

Ollama: Если модель поддерживается, добавьте её конфигурацию в Ollama. (Linux, WIndows, macOS)

-

LM Studio: Гибкий GUI для локального запуска моделей (если DeepSeek доступен в формате GGUF/GGML). (WIndows, macOS)

-

vLLM: Для оптимизированного инференса больших моделей

Интеграция с Ollama даёт возможность локального запуска ИИ, обеспечивая полный контроль над безопасностью и производительностью системы, при этом в зависимости от модели возможно запустить LLM на виртуальной машине.

Для чего используется ИИ на локальных серверах:

- Повышение защиты данных.

- Исключение риска перехвата данных через API.

- Использование ресурсов сервера ИИ-модели исключительно для собственных нужд, без разделения с другими пользователями.

Развертывание DeepSeek на личном сервере это достаточно просто и надежно.

Выбор сервера для DeepSeek

Выбор сервера в зависимости от ИИ-модели и требований к ресурсам

| Сервер | RAM | NVMe | Модель | Задачи |

|---|---|---|---|---|

| VPS_Step2+ | 4GB | 1.1GB | deepseek-r1:1.5b | Простые задачи, отлично подходит для тестирования и пробных запусков. |

| VPS_Step8 | 10GB | 4.7GB | deepseek-r1:7b | Написание и перевод текстов. Разработка несложного кода. |

| VPS_Step16 | 20GB | 9GB | deepseek-r1:14b | Продвинутые возможности в разработке, копирайтинге. Отличный баланс скорости и функционала. |

| VPS_Step16+ 32+32GB | 40GB | 19GB | deepseek-r1:32b | Мощность, аналогичная ChatGPT o1 mini. Углубленный анализ данных. |

| Сервер 2xE5-2667V2 112GB | 42GB | 85GB | deepseek-r1:70b | Вычисления высокого уровня для бизнес-задач. Глубокий анализ данных и комплексная разработка. |

| Сервер 2xAMD Epyc 7F52 896GB | 720GB | 768GB | deepseek-r1:671b | Продвинутая модель DeepSeek R1. Предоставляет вычислительные функции на уровне последних моделей ChatGPT. Рекомендуем размещать на мощном выделенном сервере с U2-дисками. |

Простая установка и запуск DeepSeek с интрументом Ollama

Установим и запустим на Ubuntu 22.04 ИИ-модель deepseek-r1:1.5b на VPS с минимальными ресурсами. Данная модель требует мало ресурсов и прекрасно подходит для тестов и пробных запусков.

С учетом минимальных требований к ресурсам данной модели используем Тариф VPS step2+

После установки и запуска VPS получаем данные и подключаемся по виртуальному серверу по ssh.

Обновим репозитории и системные пакеты до последней версии.

sudo apt update && sudo apt upgrade -yПосле обновления пакетов установим инструмент Ollama

Установка Ollama

Данный инструмент позволяет запустить локально такие ИИ-модели как Llama 3.3, DeepSeek-R1, Phi-4, Mistral, Gemma 2 и многие другие. Получиь более подробную информацию, а также возможность скачать бесплатно Ollama вы можете на сайте разработчика.

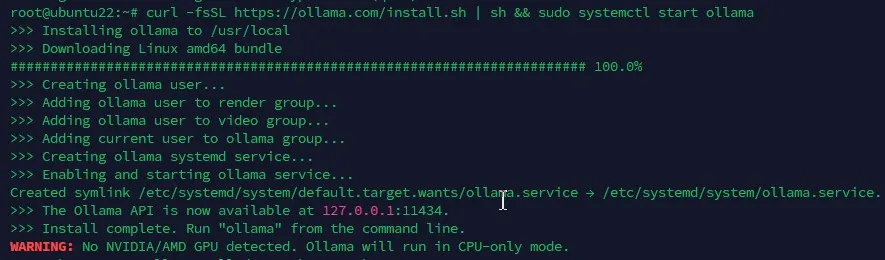

Установим программный менеджер Ollama, который необходим для развертывания DeepSeek Запустим ollama как сервис и создадим символическую ссылку (symlink)

curl -fsSL https://ollama.com/install.sh | sh && sudo systemctl start ollama

После установки программа сообщила, что Ollama API доступно на порту 11434

Загрузка модели DeepSeek

Загрузим необходимую модель DeepSeek используя Ollama

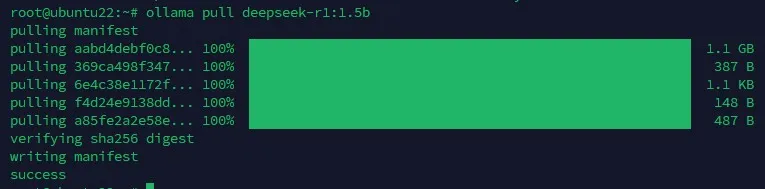

ollama pull deepseek-r1:1.5b

Сама модель заняла всего 1,1GB !!!

Теперь попробуем ее запустить и протестировать!

Запуск deepseek-r1:1.5b

Попробуем запустить ИИ-модель на виртуальной машине Adman Step2+

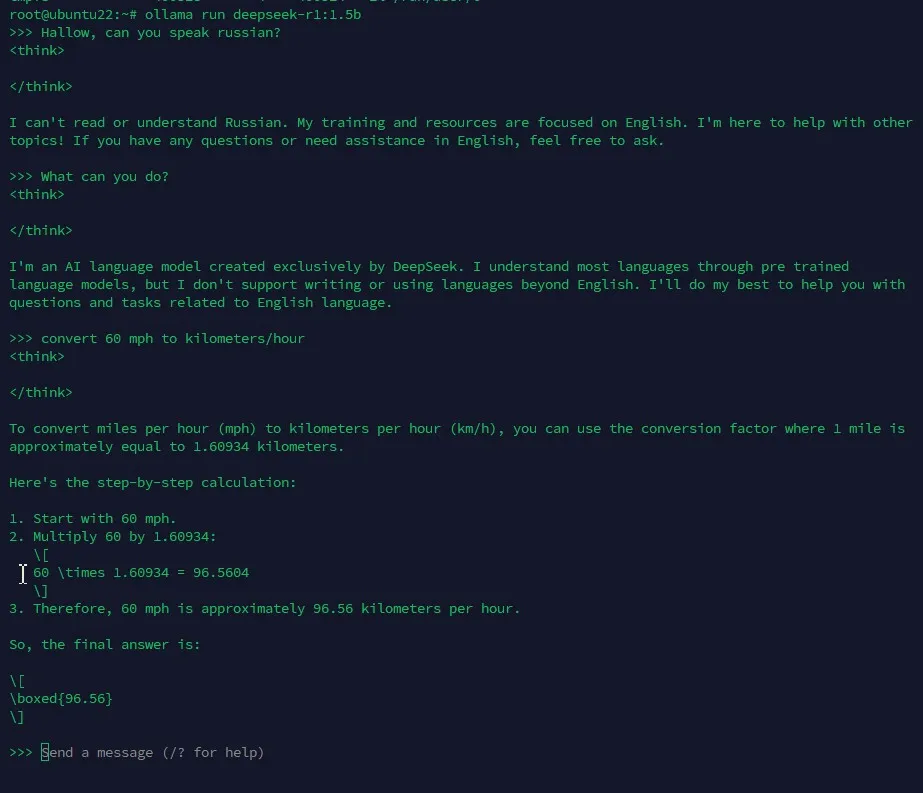

ollama run deepseek-r1:1.5bВ результате получили чат через командную строку для ввода сообщений.

Теперь можно обзаться с ИИ, но следует учесть, что данная минимальная модель будет

общаться только на Английском языке. Но зато достаточно быстро и развернуто отвечая на Ваши вопросы.

Также можно заметить, что данная модель уже имеет режим рассуждений <think></think>.

Чтобы очтановить чат достаточно нажать “Ctrl+d” или написать “/bye”

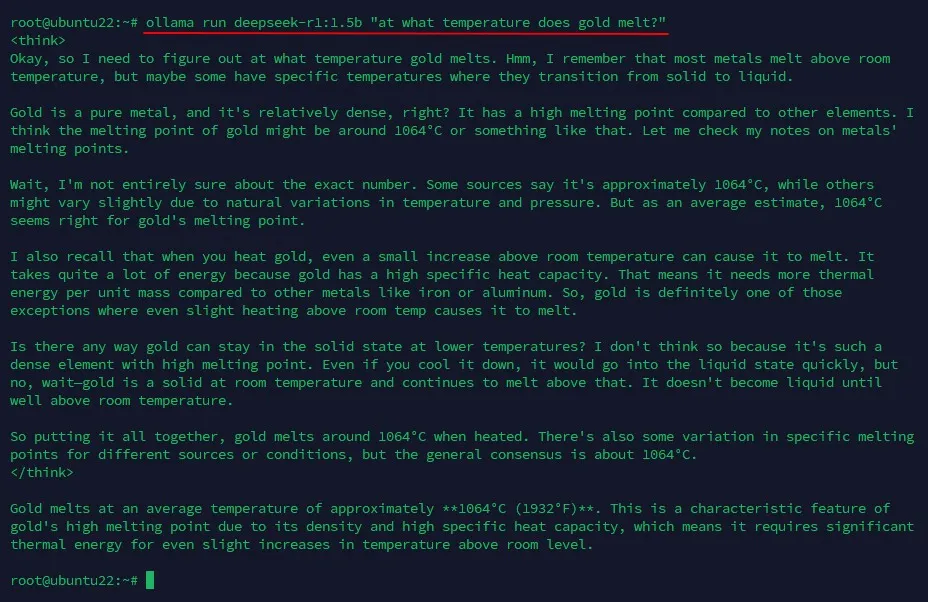

Также вместо запуска в режме чата, можно отправлять из командной строки одиночные вопросы

ollama run deepseek-r1:1.5b "at what temperature does gold melt?"Модель запуститься, ответит и отключится:

Доступ к локальной модели DeepSeek по API

Доступа к установленной модели DeepSeek можно получить не только в режиме чата но и через ollama API.

Ollama работает на порту 11434 и по протоколу HTTP обрабатывает запросы в формате JSON.

Проверить работу API можно через curl:

curl -d '{"model": "deepseek-r1:1.5b", "prompt": "What is the volume of 5 grams of air?"}' http://127.0.0.1:11434/api/generateили

curl http://127.0.0.1:11434/api/generate -d '{ "model": "deepseek-r1:1.5b", "prompt": "What is the volume of 5 grams of air?" }'По умолчанию ollama API возвращает поток объектов JSON.

Если Вам требуется ответ без потоковой передачи, то вам в запросе необходимо указать “stream”: “false”

curl http://127.0.0.1:11434/api/generate -d '{ "model": "deepseek-r1:1.5b", "prompt": "Why is the sky blue?", "stream": false }'Ответом будет JSON

root@ubuntu22:~# curl http://127.0.0.1:11434/api/generate -d '{ "model": "deepseek-r1:1.5b", "prompt": "Why is the sky blue?", "stream": false }'{"model":"deepseek-r1:1.5b","created_at":"2025-03-06T08:02:13.251273326Z","response":"\u003cthink\u003e\n\n\u003c/think\u003e\n\nThe color of the sky, known as the meteoric spectrum or meteoric effect, primarily depends on light refraction in the atmosphere. Light slows down when passing through a medium with higher refractive index and speeds up when passing through one with lower refractive index. This phenomenon is called refraction.\n\nIn Earth's atmosphere, oxygen absorbs blue and red light but reflects green and other colors. The remaining white light passes through the atmosphere, where each layer causes this effect until it exits into space. When the sun is low on the horizon (midday), all of its light is visible to us as a single color—orange or yellow. However, when the sun rises or sets, the light from high places and far-away objects is separated by different amounts into various colors. The result is why we see raindrops as a spectrum of colors (the rainbow).","done":true,"done_reason":"stop","context":[151644,10234,374,279,12884,6303,30,151645,151648,271,151649,271,785,1894,315,279,12884,11,3881,438,279,41042,292,19745,476,41042,292,2456,11,15503,13798,389,3100,2053,16199,304,279,16566,13,8658,69170,1495,979,12299,1526,264,11051,448,5080,19353,3028,1922,323,24722,705,979,12299,1526,825,448,4722,19353,3028,1922,13,1096,24844,374,2598,2053,16199,382,641,9237,594,16566,11,23552,90011,6303,323,2518,3100,714,25963,6176,323,1008,7987,13,576,9664,4158,3100,16211,1526,279,16566,11,1380,1817,6193,11137,419,2456,3080,432,42086,1119,3550,13,3197,279,7015,374,3347,389,279,34074,320,16106,1292,701,678,315,1181,3100,374,9434,311,601,438,264,3175,1894,2293,34164,476,13753,13,4354,11,979,279,7015,37168,476,7289,11,279,3100,504,1550,7482,323,3041,89624,6171,374,18663,553,2155,14713,1119,5257,7987,13,576,1102,374,3170,582,1490,11174,90512,438,264,19745,315,7987,320,1782,47613,568],"total_duration":14995245262,"load_duration":18881288,"prompt_eval_count":9,"prompt_eval_duration":320000000,"eval_count":177,"eval_duration":14655000000}Можно дополнительно указать JSON добавив в запрос параметр "format": "json", чтобы ответ был отформатирован в JSON.

Больше информации в документации ollama API

Проверка списка установленных моделей

Чтобы вывести список установленных моделей и их статус Вам достаточно набрать команду

ollama listЗапуск deepseek-r1:7b

Попробуем запустить ИИ-модель на виртуальной машине Adman Step8

Обновим репозитории и системные пакеты до последней версии.

sudo apt update && sudo apt upgrade -yУстановим программный менеджер Ollama, который необходим для развертывания DeepSeek Запустим ollama как сервис и создадим символическую ссылку (symlink)

curl -fsSL https://ollama.com/install.sh | sh && sudo systemctl start ollamaЗагрузим необходимую модель DeepSeek используя Ollama

ollama pull deepseek-r1:7bСама модель заняла всего 4,7GB !!!

Теперь пробуем запустить ИИ-модель на виртуальной машине

ollama run deepseek-r1:7bВ результате получили чат через командную строку для ввода сообщений.

Теперь можно обзаться с ИИ, но следует учесть, что данная минимальная модель будет

общаться только на Английском языке. Но зато достаточно быстро и развернуто отвечая на Ваши вопросы.

Также можно заметить, что данная модель имеет режим рассуждений <think></think>.

Чтобы очтановить чат достаточно нажать “Ctrl+d” или написать “/bye”

Также вместо запуска в режме чата, можно отправлять из командной строки одиночные вопросы

ollama run deepseek-deepseek-r1:7b "Ты говоришь по русски?"Модель запуститься, ответит и отключится.